Hyper-parameters Tuning in Machine Learning

การปรับแต่ง Hyper-parameters เพื่อประสิทธิภาพของ Machine Learning Model ที่ดีขึ้น เป็นงานที่สำคัญที่สุดอันหนึ่งของ Data Scientist แม้ว่าการเลือก Algorithm ที่ถูกต้องและการประมวลผลข้อมูลล่วงหน้า (Data Pre-processing) ที่ดี ถือเป็นสิ่งสำคัญ แต่การทำ Model Hyper-parameters fine tuning สามารถสร้างความแตกต่างอย่างมีนัยสำคัญในเรื่อง Accuracy, Precision, Recall และประสิทธิภาพโดยรวม

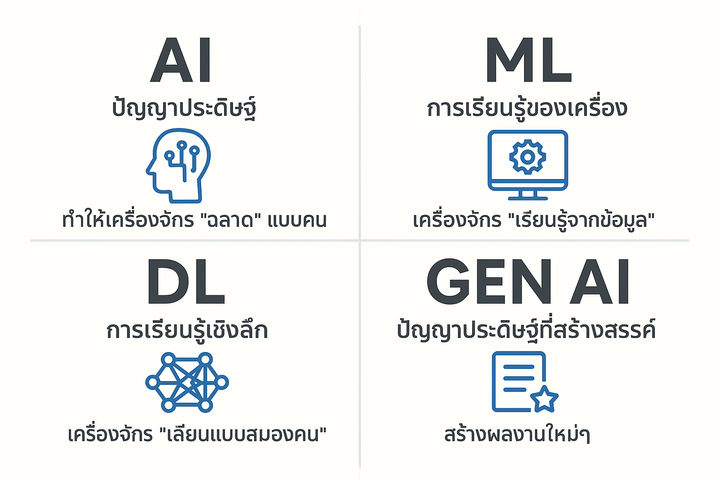

Hyper-parameters คือ การกำหนดค่าที่ควบคุมกระบวนการเรียนรู้ของ ML Algorithm ต่างจาก Models’ parameters ซึ่งเรียนรู้จาก Training data จำเป็นต้องตั้งค่า Hyper-parameters ด้วยตนเองก่อนที่ทำการ Train Model ตัวอย่างของ Hyper-parameters ได้แก่ อัตราการเรียนรู้ในโครงข่ายประสาทเทียม (Neural Network) จำนวน Trees ใน Random Forest หรือ Regularization ใน Linear Model

การปรับ Hyper-parameters เหล่านี้ มีความสำคัญเนื่องจากค่าที่แตกต่างกันสามารถนำไปสู่ประสิทธิภาพของ Model ที่แตกต่างกันอย่างมาก หากไม่ได้รับการตั้งค่าอย่างเหมาะสม อาจส่งผลต่อ Over-fitting หรือ Under-fitting ส่งผลให้ทำงานกับ Unseen data หรือ ข้อมูลใหม่ได้ได้ไม่ดี

ตัวอย่างเทคนิคที่ใช้ทำ Hyper-parameters Tuning

- Grid Search: เป็นวิธีที่ตรงไปตรงมาที่สุด โดยกำหนดช่วงของค่าสำหรับ Hyper-parameter แต่ละรายการ และประเมินประสิทธิภาพของ Model โดยทดลองใช้ทุกค่าที่เป็นไปได้ แม้ว่าการคำนวณจะมีต้นทุนสูง แต่ก็ทำได้ครบถ้วนและรับประกันว่า จะพบส่วนผสมของ Hyper-parameters ที่เหมาะสมที่สุดภายในช่วงที่ระบุ

- Random Search: แทนที่จะประเมินทุกค่าที่เป็นไปได้ของ Hype-parameters วิธีการนี้จะสุ่มตัวอย่างจากช่วงที่กำหนด มักจะมีประสิทธิภาพมากกว่า Grid Search โดยเฉพาะอย่างยิ่งเมื่อต้องจัดการกับ Hyper-parameters ที่มีจำนวนมาก หรือเมื่อ Hyper-parameter บางตัวมีผลกระทบอย่างมีนัยสำคัญต่อประสิทธิภาพของ Model

- Bayesian Optimization: เทคนิคนี้ใช้การอนุมานแบบเบย์เพื่อค้นหา Hyper-parameters ที่เหมาะสมที่สุดซ้ำๆ การเพิ่มประสิทธิภาพแบบเบย์จะสร้าง Probability Model ของ Objective Function (เช่น Model Accuracy) จากการประเมินครั้งก่อน และใช้ Acquisition Function เพื่อกำหนด Hyper-parameters ชุดถัดไปที่จะทำการประเมิน แนวทางนี้มีประสิทธิภาพและสามารถค้นหาวิธีแก้ปัญหาที่ดี โดยมีการประเมินน้อยกว่าเมื่อเทียบกับ Grid Search หรือ Random Search

- Gradient-based Optimization: ในบางกรณี เป็นไปได้ที่จะถือว่า Hyper-parameters เป็น Weights เพิ่มเติมของ Model และ ใช้ Gradient-based Optimization เช่น Stochastic Gradient Descent วิธีการนี้มีประโยชน์มาก สำหรับโครงข่ายประสาทเทียมและ Deep Learning Models ซึ่งจำนวน Hyper-parameters มีขนาดใหญ่

- Ensemble Methods: แทนที่จะพยายามค้นหา Hyper-parameters ที่เหมาะสมที่สุดเพียงชุดเดียว วิธีการนี้จะรวมหลาย Models เข้าด้วยกัน โดยกำหนดค่า Hyper-parameters ที่แตกต่างกัน เช่น Bagging และ Boosting มักจะมีประสิทธิภาพดีกว่า Model เพียง Model เดียว

ไม่ว่าจะเลือกใช้เทคนิคใด จำเป็นต้องแยกข้อมูลออกเป็น Training และ Test data ใช้ Training data ในการ Fit (Train) Model ชุดการตรวจสอบเพื่อปรับแต่งไฮเปอร์พารามิเตอร์ และชุดทดสอบเพื่อประเมินประสิทธิภาพขั้นสุดท้ายของโมเดลที่ปรับให้เหมาะสมที่สุดของคุณ

การทำ Hyper-parameters Tuning อาจเป็นกระบวนการที่ใช้เวลานานและมีต้นทุนสูง แต่เป็นขั้นตอนสำคัญในการสร้าง ML Model ที่มีประสิทธิภาพ หากเชี่ยวชาญเทคนิคเหล่านี้ จะสามารถปลดล็อกศักยภาพของ Algorithm ที่เลือกใช้ได้อย่างเต็มที่

หมายเหตุ: Blog นี้ เขียนร่วมกับ Claude.ai โดยใช้ Prompt

Act as a data scientist, please write a blog of hyper-parameters tuning.